大数据一词被新事物的现代奇妙夸张所破坏。 随着AI奴役人们并区块链构建理想的经济-大数据将使您绝对了解所有人的一切并看到未来。

但是现实一如既往地更加无聊和务实。 大数据没有魔力-无处不在-不同数据之间的信息和联系太多了,以旧的方式处理和分析所有内容都花费了很长时间。

新方法正在出现。 新的职业伴随着他们。

GeekBrains大数据分析部门的负责人谢尔盖·舍尔

金( Sergey Shirkin)表示,他们是什么专业,需要什么专业,需要做什么以及需要做什么。 使用什么工具,通常向专家支付多少费用。

什么是大数据?

“什么叫大数据”这个问题相当令人困惑。 即使在科学期刊中,描述也有所不同。 在某个地方,数百万个观测值被视为“普通”数据,而在其他地方,数十万个观测值被称为大数据,因为每个观测值都有一千个符号。 因此,他们决定根据最简单的原则将数据有条件地分为三部分-小,中和大:它们占据的容量。

小数据只有几GB。 中-有关TB的一切。 大数据约为PB。 但这并没有消除混乱。 因此,条件甚至更简单:不在同一服务器上的所有内容都是大数据。

小数据,中数据和大数据具有不同的操作原理。 大数据通常一次存储在几台服务器的群集中。 因此,即使简单的动作也更加复杂。

例如,一个简单的任务是找到数量的平均值。 如果这是小数据,我们只需要相加并除以数量即可。 在大数据中,我们无法一次从所有服务器收集所有信息。 这很复杂。 通常,您不需要自己提取数据,而只需将单独的程序发送到每台服务器。 经过这些程序的工作,形成中间结果,并由它们确定平均值。

谢尔盖·舍金(Sergey Shirkin)

谢尔盖·舍金(Sergey Shirkin)什么大数据公司

第一个拥有大数据的公司开始为移动运营商和搜索引擎服务。 搜索引擎的查询越来越多,文本比数字还重。 处理一段文字要比进行财务交易花费更多的时间。 用户希望搜索引擎在一秒钟内完成请求-即使工作半分钟也无法接受。 因此,搜索引擎在处理数据时首先开始使用并行化。

不久之后,各种金融组织和零售业也加入了进来。 事务本身并不那么繁琐,但是由于存在大量事务,因此出现了大数据。

数据量正在不断增长。 例如,银行以前拥有大量数据,但是与大型银行一样,它们并不总是需要工作原理。 然后,银行开始更多地处理客户数据。 他们开始提出更灵活的存款,贷款,不同的关税,并开始更紧密地分析交易。 这已经需要快速的工作方式。

现在,银行不仅要分析内部信息,还要分析外部信息。 他们想从同一家零售店接收数据,他们想知道一个人花钱在哪里。 基于这些信息,他们正在尝试提供商业报价。

现在,所有信息都相互关联。 零售,银行,电信运营商甚至搜索引擎-现在每个人都对彼此的数据感兴趣。

大数据专家应该是什么

由于数据位于服务器群集上,因此使用了更复杂的基础结构来处理它们。 这给与她一起工作的人带来了沉重的负担-系统必须非常可靠。

使一台服务器可靠很容易。 但是,当它们中的几个存在时,下降的可能性与数量成正比,并且处理此数据的数据工程师的责任也会增加。

分析人员必须了解,他总是会收到不完整甚至错误的数据。 他编写了该程序,并对其结果表示信任,然后发现由于千台服务器中的一台服务器跌落,部分数据已断开连接,所有结论均不正确。

以文本搜索为例。 假设所有单词在多个服务器上均按字母顺序排列(如果我们非常简单且有条件地讲)。 其中一个断开连接,字母“ K”中的所有单词都消失了。 搜索停止给出单词“电影院”。 新闻的所有新闻都消失了,分析家做出了一个错误的结论,即人们不再对电影院感兴趣。

因此,大数据专家应该从最低级别(服务器,生态系统,任务计划者)到最高级别程序(机器学习库,统计分析等),了解工作原理。 他必须了解熨斗,计算机设备的原理以及在其上面配置的所有东西。

其余的,您需要了解与处理小数据时相同的所有知识。 您需要数学,需要编程,尤其是对分布式计算算法有很好的了解,才能将它们应用于处理数据和机器学习的通常原理。

使用什么工具

由于数据存储在群集中,因此需要特殊的基础结构来使用它。 最受欢迎的生态系统是Hadoop。 可以在其中使用许多不同的系统:特殊的库,计划程序,用于机器学习的工具等等。 但是首先,由于分布式计算,需要使用该系统来处理大量数据。

例如,我们正在寻找在一千台服务器上断开的数据中最受欢迎的推文。 在一台服务器上,我们只需要一张桌子就可以了。 在这里,我们可以将所有数据拖到自己身上并重新计数。 但这是不对的,因为很长一段时间。

因此,存在具有Map Reduce范例和Spark框架的Hadoop。 他们没有向自己提取数据,而是向这些数据发送程序段。 工作并行进行,有上千个线程。 然后,我们可以选择成千上万的服务器,您可以根据这些服务器选择最受欢迎的推文。

Map Reduce是较旧的范例; Spark是较新的范例。 借助它的帮助,从集群中提取数据,并在其中构建机器学习模型。

大数据领域有哪些专业

两个主要专业是分析师和数据工程师。

分析人员主要处理信息。 他对表格数据感兴趣,并且从事模型研究。 他的职责包括数据的聚合,净化,添加和可视化。 也就是说,分析师是原始信息和业务之间的链接。

分析师有两个主要工作领域。 首先,他可以转换接收到的信息,得出结论并以一种易于理解的方式呈现出来。

第二个是分析人员开发可以自动运行并产生结果的应用程序。 例如,每天对证券市场进行预测。

数据工程师是较低级别的专业。 这是必须确保将信息存储,处理和传递给分析人员的人员。 但是在有供应和清洁的地方-他们的职责可能会重叠。

数据工程师辛辛苦苦。 如果系统出现故障,或者其中一台服务器从群集中消失,它将连接。 这是一项非常负责和压力很大的工作。 该系统可以在周末和下班时间关闭,工程师必须立即采取措施。

这是两个主要职业,但还有其他职业。 当将并行计算算法添加到与人工智能相关的任务时,它们就会出现。 例如,一个NLP工程师。 这是一位从事自然语言处理的程序员,特别是在您不仅需要查找单词,还需要掌握文本含义的情况下。 这些工程师为聊天机器人和对话系统,语音助手和自动呼叫中心编写程序。

在某些情况下,有必要对数十亿张图片进行分类,进行审核,过滤掉多余的图片并找到相似的图片。 这些专业更多地与计算机视觉重叠。

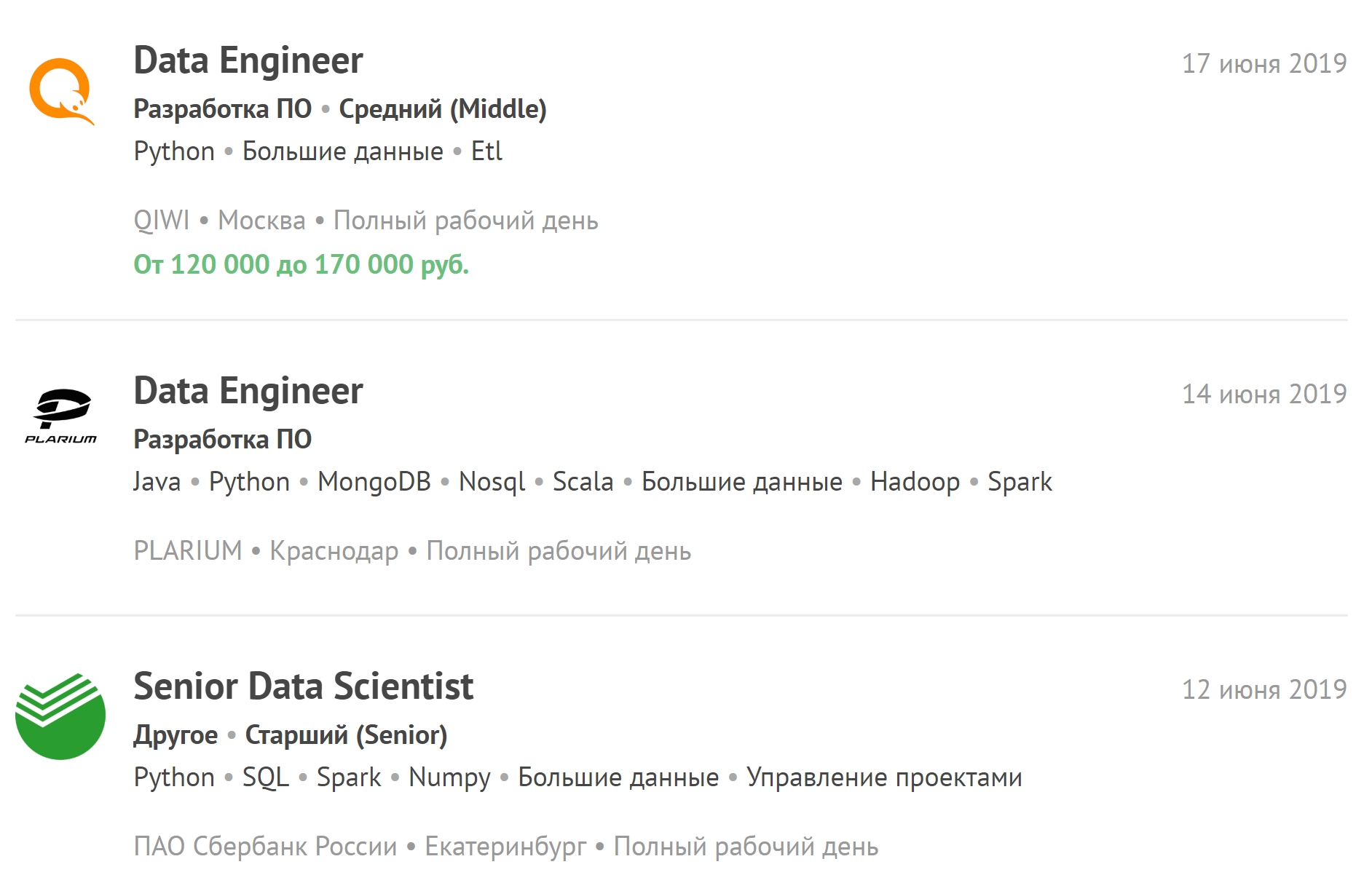

您可以查看与大数据相关的最新职位空缺并订阅新职位空缺。

培训需要多长时间

我们已经学习了一年半。 他们分为六个季度。 在某些情况下,强调编程,在其他方面则强调使用数据库,在第三方面则强调数学。

相比之下,例如,来自AI系的数学就更少了。 对数学分析和线性代数没有如此强调。 分布式计算算法的知识比成熟分析的原理更重要。

但是只有当一个人拥有处理普通数据以及一般IT方面的经验时,一年半就足以进行大数据的实际工作。 建议毕业后的其余学生使用中小型数据。 只有这样,才能允许专家与大型专家合作。 培训之后,您应该作为数据科学家工作-将机器学习应用于不同数量的数据。

当一个人在一家大公司找到工作时(即使他有经验),通常大多数情况下他都不被允许立即去大数据,因为错误的代价会更高。 可能不会立即检测到算法中的错误,这将导致巨大的损失。

大数据专家认为什么薪水合适

现在,数据工程师之间的人员短缺非常大。 工作困难,很多责任落在一个人身上,很多压力。 因此,具有平均经验的专家可获得约二十万。 初级-一百到两百。

数据分析师的起薪可能会略低。 但是没有超出工作时间的工作,由于紧急情况,他不会在非工作时间被召唤。

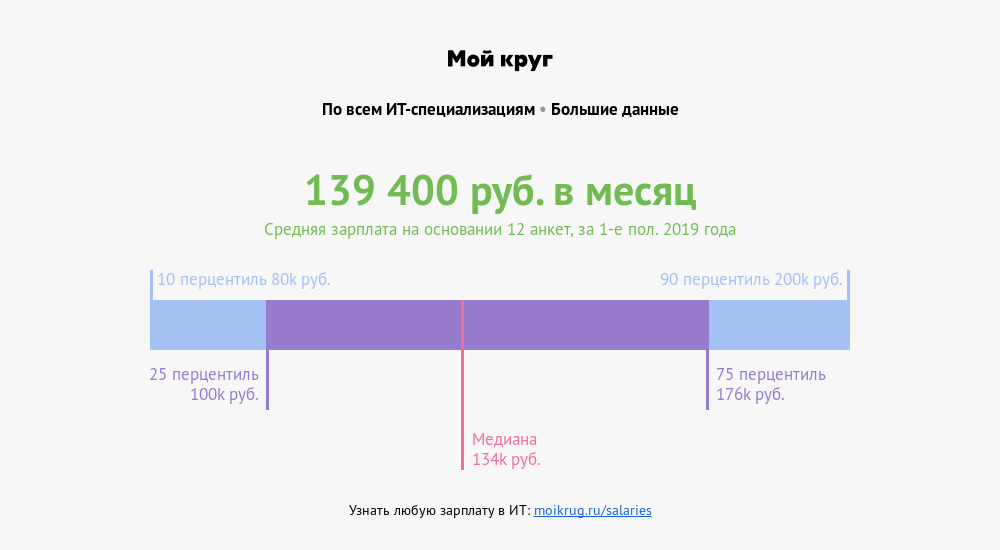

根据“我的圈子”的薪资培养者所说,与大数据相关的专业人士的平均工资为139,400卢布 。 四分之一的专家收入超过176,000卢布。 十分之一-超过200,000卢布。

如何准备面试

无需深入研究一个主题。 在面试中,他们询问有关统计,机器学习,编程的问题。 他们可能会询问现实生活中的数据结构,算法和案例:服务器崩溃,发生了事故-如何解决? 在主题领域可能存在疑问-与业务更接近的问题。

而且,如果一个人过于精通数学,并且在面试时没有做简单的编程任务,那么找工作的机会就会减少。 在每个方向上都具有平均水平比在一个方向上展现自己好,而在另一个方向上完全失败要好。

在80%的面试中都有一个问题清单。 如果这是机器学习,他们肯定会问梯度下降。 如果是统计数据-您将需要谈论相关性和假设检验。 编程可能会给中等难度的小任务。 而且您可以轻松完成任务-只需解决更多问题即可。

在哪里获得经验

可以在

Pitontutyu上

安装 Python,并在

SQL-EX上与数据库一起使用。 在实践中,他们学会了提出要求的任务。

高等数学

-Mathprofi 。 在那里,您可以获得有关数学分析,统计和线性代数的清晰信息。 如果这对学校的课程不利,那就是

youclever.org 。

分布式计算只会在实践中起作用。 首先,这需要基础架构,其次,算法可能会很快过时。 现在,新事物不断出现。

社区讨论什么趋势

另一个领域正在逐渐增强,这可以导致数据量的快速增长-物联网(IoT)。 此类数据来自网络中连接的设备的传感器,并且在下一个十年开始时,传感器的数量应达到数百亿。

这些设备非常不同-从家用电器到车辆和工业机器,不断的信息流需要更多的基础架构和大量的高素质专家。 这意味着在不久的将来,数据工程师和大数据分析师将严重短缺。