关于华为在使用AI Fabric技术组织远程直接内存访问时提供了什么方法以及与InfiniBand和基于纯以太网的RDMA有何不同的主题。

分布式计算被广泛用于各种行业。 这些是科学研究和技术发展,例如人脸识别或自动驾驶仪识别工具,以及工业。 总的来说,数据分析正在发现越来越多的应用程序,我们可以充满信心地说,在不久的将来它不会失去流行性。 实际上,现在我们正在经历一个从云计算时代(其中最重要的因素是应用程序和服务部署速度)到数据货币化时代(包括通过使用人工智能算法)的过渡。 根据我们的内部数据(

GIV报告

2025:展现智能世界的产业蓝图 ),到2025年,将有86%的公司在其工作中使用AI。 他们中的许多人认为这一领域是活动现代化的主要内容,并且可能是将来制定业务决策的基本工具。 这意味着这些公司中的每一个都将需要某种原始数据的处理-最有可能通过分布式集群进行。

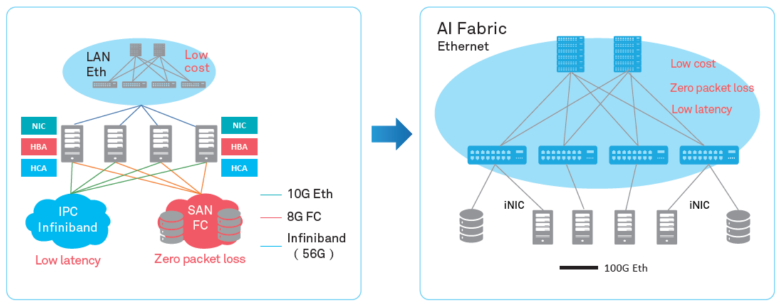

建筑的演变

随着分布式计算的日益普及,各个数据中心机器之间交换的通信量增加了。 传统上,在讨论网络时,注意力集中在数据中心和Internet上最终用户之间的流量增长上,并且确实在增长。 但是分布式系统中水平流量的增加远远超过了用户产生的一切。 根据Facebook的说法,其内部系统之间的流量在不到一年的时间内翻了一番。

为了应对这种流量,您可以增加群集,但是不能无限期地这样做。 因此,预测群集上计算负载的增长,有必要提高处理效率-首先,要找到并消除这些分布式网络内部的瓶颈。

如果说以前分布式系统的“弱链接”分别是每个系统的资源,而不断发展的数据传输网络甚至超出了需求,那么今天,网络通信是问题的主要根源。 熟悉的TCP / IP协议栈和树形拓扑不再对应于分配的任务。 因此,越来越多的数据中心放弃了集中式数据中心,而转向一种新的CLOS体系结构,该体系结构提供了更大的带宽和更好的群集可伸缩性,例如几年前的Facebook。

同时,有必要在不同级别上优化流程-在两个独立系统的交互级别上。 在本文中,我们想谈谈华为Ai Fabric数据中心提供哪些优化工具。 这是我们的专有技术,可加速节点之间的数据交换。

网络变化

华为Ai Fabric的主要“窍门”是通过实现RDMA(远程直接内存访问)来减少在群集内系统之间传输数据包时的开销-直接访问群集内系统的内存。

RDMA-一种减少传输延迟的方法

RDMA不是一个新主意。 该技术提供了内存与网络接口之间的直接数据交换,从而减少了等待时间,并消除了不必要的数据复制到缓冲区的情况。 它的历史可以追溯到1990年的Compaq,Intel和Microsoft。

将数据包从一个系统传输到另一个系统有三种类型的延迟:

- 由于需要处理器处理,例如,在OS中缓冲数据和计算校验和;

- 由于总线和数据传输通道(在技术上不可能显着增加带宽);

- 由于网络设备。

为了减少整个链条中的损失,早在1990年代,就提出了使用直接访问交互系统内存的方法-虚拟接口体系结构的抽象模型。 它的主要思想是在两个交互系统上运行的应用程序完全填充其本地内存,并建立用于数据传输的P2P连接,而不影响操作系统。 这样,可以显着减少分组传输延迟。 另外,由于VIA模型并不意味着将传输的数据放在中间缓冲区中,因此它节省了复制操作所需的资源。

关于抽象模型,VIA RDMA作为一项技术,已进一步朝着最佳资源利用迈进了一步。 特别是,它不等待缓冲区被填满以建立连接,而是允许同时连接到多台计算机。 因此,该技术可以将传输延迟减少多达1 ms,从而减少了处理器的负载。

InfiniBand与以太网

不幸的是,市场上两个主要的RDMA实现-专有的InfiniBand传输协议和基于“纯”以太网的RDMA,并非没有缺点。

InfiniBand传输协议具有内置的数据包传递控制机制(数据丢失保护),但受特定设备支持,并且与以太网不兼容。 实际上,使用该协议会使一个设备供应商的数据中心关闭,这将带来一定的风险并在服务方面带来困难(由于InfiniBand的市场份额很小,因此很难找到专家)。 好吧,当然,在实施协议时,您不能使用现有的IP网络设备。

以太网RDMA允许您使用网络上的现有设备,支持以太网,这意味着将更容易找到服务专家。 与Infiniband相比,这显着降低了基础架构的拥有成本并简化了其部署。

阻止RDMA在以太网上广泛采用的唯一严重缺陷是缺乏防止丢包的保护,这限制了整个网络的带宽。 必须使用第三方机制来减少数据包丢失或防止网络拥塞。 我们就是这样,提供了自己的智能算法来补偿RDMA在以太网上的缺点,同时在新工具Huawei Ai Fabric中保持其优势。

华为AI Fabric-它的方式

AI Fabric实现了以太网上的RDMA,并辅以其自己的智能网络拥塞管理算法,可为RDMA流提供零丢包,高网络带宽和低传输延迟。

华为Ai Fabric建立在开放标准之上,支持多种不同的设备,从而优化了实施过程。 但是,某些其他工具(基于开放标准的附加组件可以提高数据交换的效率,我们将在后续出版物中进行讨论)仅适用于华为制造的设备。 支持该解决方案的CloudEngine系列交换机具有一个集成芯片,该芯片可以分析流量特性并动态调整网络参数,从而可以更高效地使用交换机缓冲区。 收集的特征还用于预测未来的流量模式。

这对谁有用?

华为Ai Fabric可让您从两个层次上获利。

一方面,该解决方案允许优化数据中心架构-减少节点数量(由于资源的更优化利用),创建了一个融合环境,而无需传统地分成单独的子网,这很难部分维护且成本很高。 使用该工具,您不必为域控制器中的每种服务选择单独的子网(具有其自己的网络要求)。 您可以创建一个提供所有服务的环境。

另一方面,AI Fabric使您可以提高分布式计算的速度,尤其是在您经常需要访问远程系统的内存的地方。 例如,在任何领域引入AI都意味着学习算法的时期,其中可能包括数百万个操作,因此每次此类操作的延迟增加将导致过程的严重加速。

在具有六个或更多交换机的数据中心中,引入专用工具(例如Huawei Ai Fabric)的效果将非常明显。 但是,数据中心越大,利润就越高-由于资源的最佳利用,与Ai Fabric规模相同的集群将提供更高的性能。 例如,一个384个节点的群集可以实现512个节点的“常规”群集的性能。 此外,该解决方案对基础架构中的物理交换机数量没有限制。 可能有成千上万(如果您忘记了项目通常限于管理域的大小)。