2018年,计算机语言学和机器学习领域的主要事件之一是Google AI

发行了BERT ,根据计算机语言学协会(NACL)的北美分会,该文件被认为是年度最佳报告。 在本文中,我们将讨论这种语言模型及其功能。

对于以前从未听说过的人,BERT是一个神经网络,它基于词的上下文表示形式的预备方法,即,它使用双向语言模型,还使您可以分析整个句子。 在这种情况下,也要考虑给定和之后的单词。 这种方法可以在各种自然语言处理(NLP)任务中以最先进的方式获得结果,但需要强大的计算能力。

从正式演讲到对话

BERT最初使用104种Wikipedia语言(多语言)进行教学。 除了多语言版本外,Google还发布了基于英语维基百科和中文BERT的BERT。

在神经系统和深度学习实验室中,我们使用BERT改进了DeepPavlov的NLP组件,DeepPavlov是一个开源交互库,用于开发基于TensorFlow和Keras的虚拟交互助手和文本分析。 我们在俄语Wikipedia-RuBERT上训练了BERT模型,从而大大提高了俄语模型的质量。 此外,BERT还被集成到三个流行的NLP任务的解决方案中:文本分类,序列标记和问题答案。 您可以在我们博客的最新出版物中了解有关DeepPavlov的BERT模型的更多信息:

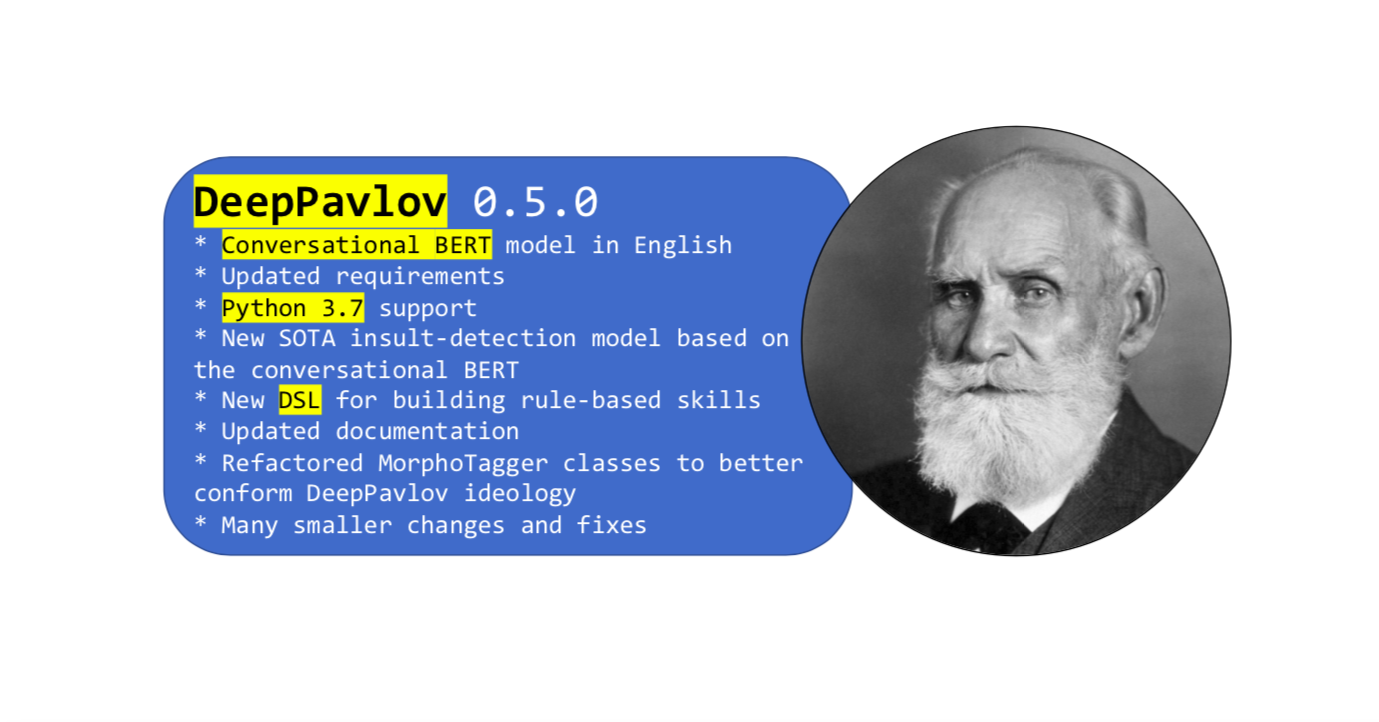

最近,该库的新版本

此更新的主要功能是BERT,该语言受过英语社交网络词汇的培训。 Wikipedia的正式语言与普通口语不同,要解决某些问题,您只需要一个即可。

对话式BERT使用来自Twitter,Reddit,DailyDialogues,OpenSubtitles,辩论,博客和Facebook新闻评论的开放数据进行了英语培训。 该数据用于将英语子标记的词汇构建到BERT的英语版本中,作为英语BERT的初始化。 结果,口语BERT在以社交数据为特色的任务中显示了最新的结果。

如何在DeepPavlov中使用会话BERT

您可以使用基于英语的BERT口语的新

Insult检测模型。 或任何其他基于BERT的模型,都使用文档中的

简单指南 。

SOTA

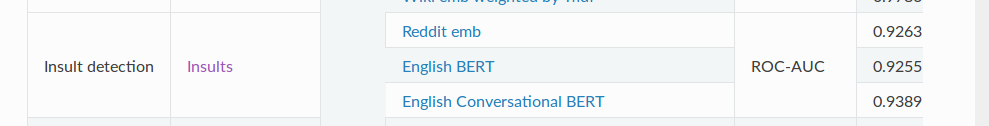

侮辱检测模型包含用于检测滥用的二进制分类任务。 对于ROC-AUC度量标准(在各种阈值设置下针对分类任务的性能测量),与通常的BERT-92.55相比,该模型在数据上显示的值为93.89。

最后

因此,这几乎是我们想要向您介绍我们的会话BERT的全部内容。 并且不要忘记DeepPavlov有一个

论坛 -提出有关库和模型的问题。 做生意!