1998年,当MNIST数据库出现时,培训最先进的计算机花费了数周的时间,其结果要比当今的计算机要差得多,后者要花费不到一个小时才能使用GPU。 因此,MNIST不再是突破技术界限的任务。 培训的速度表明,这项任务非常适合研究这项技术。 同时,研究进一步发展,现代工作研究更复杂的问题。 在本节中,我将简要描述一些与使用神经网络进行图像识别有关的正在进行的示例。

本节与本书的其余部分不同。 在这本书中,我重点研究了长期存在的想法-反向传播,正则化,卷积网络。 我试图避免在撰写本文时认为时髦的结果,而长期结果却令人怀疑。 在科学中,这种结果通常只是短暂的,很快就会消失并且没有长期影响。 鉴于此,持怀疑态度的人会说:“当然,最近在图像识别方面的进展可以看作是这种一日游的一个例子吗? 在两三年后,一切都会改变。 那么,这些结果可能会吸引少数竞争前景的专业人士感兴趣吗? 为什么要讨论它们呢?”

这样的怀疑是正确的,因为近期作品的细微之处正在逐渐失去人们所认识的重要性。 但是,在过去的几年中,使用深度神经网络(GNS)解决特别复杂的图像识别问题取得了令人难以置信的进步。 想象一下2100年一位科学史学家撰写的有关计算机视觉的材料。 他们将2011-2015年(可能是此后的几年)定义为深度卷积网络(GSS)驱动的重大突破时期。 这并不意味着GOS仍将在2100年使用,更不用说诸如异常,ReLU之类的细节了。 但这一切都意味着当前思想史上有重要的转变。 这类似于观察原子的发现,抗生素的发明:历史比例的发明和发现。 因此,无需赘述,值得对当今有趣的发现有所了解。

工作2012 LRMD

让我从由斯坦福大学和Google的一组研究人员撰写

的2012年工作开始。 我将用前四位作者的名字的首字母称呼她为LRMD。 LRMD使用NS对ImageNet数据库中的图像进行分类,这是模式识别非常困难的任务。 他们从2011年ImageNet使用的数据包括1600万张全彩色图像,分为20,000个类别。 图片是从Internet下载的,并由Amazon Mechanical Turk分类。 以下是其中一些:

它们分别属于以下类别:腮腺炎,褐木耳,巴氏杀菌牛奶,round虫。 如果您想练习,我建议您访问ImagNet的手动工具列表,这些地方的土丘,端刨,倒角刨和数十种其他类型的刨有所不同,更不用说其他类别了。 我不了解您,但是我不能确定地区分所有这些工具。 这显然比MNIST更具挑战性! LRMD网络从ImageNet获得了不错的结果,图像识别精度为15.8%。 这看起来似乎并不令人印象深刻,但与之前的9.3%的结果相比,却有了巨大的进步。 这种飞跃表明,NS可以为非常复杂的图像识别任务(例如ImageNet)提供有效的方法。

2012年KSH工作

LRMD在2012年的

工作之后是 Krizhevsky,Sutskever和Hinton(KSH)的工作。 KSH使用ImagNet数据的有限子集训练和测试了GSS。 该子集由流行的机器学习竞赛-ImageNet大规模视觉识别挑战赛(ILSVRC)定义。 使用此子集为他们提供了一种方便的方法,可以将其方法与其他领先技术进行比较。 ILSVRC 2012集包含来自1000个类别的约120万张图像。 验证和确认集分别包含来自相同1000个类别的150,000和50,000图像。

ILSVRC竞争的挑战之一是ImageNet中的许多图像包含多个对象。 例如,在图像中,拉布拉多犬追赶足球。 T.N. ILSVRC的“正确”分类可能对应于拉布拉多犬标签。 如果将图像标记为足球,是否需要从算法中选择点? 由于这种模糊性,如果ImageNet分类是该算法关于图像内容的5个最可能猜测之一,则该算法被认为是正确的。 根据这一标准,KSH的GSS在前5名中达到了84.7%的准确度,远胜于前一个对手的73.8%的准确度。 使用更严格的度量标准,当标签必须完全符合规定时,KSH准确性达到63.3%。

值得简要描述KSH网络,因为它启发了随后的许多作品。 正如我们将看到的,它也与我们在本章中训练的网络紧密相连,尽管它更为复杂。 KSH使用了在两个GPU上训练过的GSS。 他们使用了两个GPU,因为其特定的卡(NVIDIA GeForce GTX 580)没有足够的内存来存储整个网络。 因此,他们将网络分为两个部分。

KSH网络具有7层隐藏的神经元。 前五个隐藏层是卷积的(有些使用最大池),接下来的两个是完全连接的。 输出的softmax层由对应于1000个图像类别的1000个神经元组成。 这是网络的草图,摘自KSH的工作。 详细说明如下。 请注意,许多层分为对应于两个GPU的2部分。

在输入层中,有一个3x224x224神经元,指示224x224大小的图像的RGB值。 回想一下ImageNet包含各种分辨率的图像。 由于输入网络层通常具有固定的大小,所以这带来了问题。 KSH通过缩放每个图像以使其短边的长度为256像素来处理此问题。 然后,他们从调整大小后的图像中间切出一个256x256像素的区域。 最后,KSH从256x256图像中检索到随机的224x224图像片段(及其水平反射)。 这种随机剪切是扩展训练数据以减少再训练的一种方法。 这尤其有助于训练像KSH这样的大型网络。 最后,这些224x224图像用作网络的输入。 在大多数情况下,裁剪后的图像包含原始图像中的主要对象。

我们进入KSH网络的隐藏层。 第一隐藏层是卷积的,具有最大牵引步骤。 它使用大小为11x11的局部接收场,步长为4个像素。 总共可获得96张功能卡。 角色卡分为两组,每组48个,前48个卡在一个GPU上,第二个在另一个GPU上。 此层和后续层中的最大池化由3x3部分执行,但合并部分可以重叠,并且彼此之间的距离仅为2个像素。

第二个隐藏层也是卷积的,具有最大池化。 它使用本地5x5接收字段,并且具有256个功能卡,每个GPU分为128个。 要素地图通常仅使用48个进入通道,而不是上一层的所有96个出口。 这是因为任何功能卡都从存储它的GPU接收输入。 从这个意义上讲,网络正在远离我们在本章前面描述的卷积体系结构,尽管很明显,基本思想仍然是相同的。

第三,第四和第五层是卷积的,但没有最大池化。 它们的参数:(3)384个特征图,局部接收场3x3,256个输入通道; (4)384个特征图,局部接收场3x3,192个输入通道; (5)256个功能卡,本地接收区域3x3,192个输入通道。 在第三层上,在GPU之间交换数据(如图所示),以便功能图可以使用所有256个输入通道。

第六和第七个隐藏层完全连接,每个4096个神经元。

输出层是softmax,由1000个单位组成。

KSH网络利用了许多技术。 它没有使用Sigmoid或双曲正切作为激活函数,而是使用ReLU,这大大加快了学习速度。 KSH网络包含大约6,000万个训练参数,因此,即使具有大量训练数据,也要对其进行重新训练。 为了解决这个问题,如上所述,作者通过随机裁剪图片扩展了训练集。 然后,他们使用了L2正则化变体和例外。 该网络使用基于动量的随机梯度下降和迷你数据包进行训练。

本文简要概述了KSH的许多关键见解。 我省略了一些细节;您可以在文章中自行查找。 您还可以查看Alex Krizhevsky

cuda-convnet (及其追随者)的项目,其中包含实现上述许多思想的代码。 还

开发了 基于Theano的该网络

的版本。 您可以在代码中识别出与本章中开发的想法类似的想法,尽管使用多个GPU会使事情变得复杂。 Caffe框架具有自己的KSH网络版本,有关详细信息,请参见其“

动物园模型 ”。

2014年ILSVRC比赛

自2012年以来,进展非常迅速。 参加2014年ILSVRC比赛。 与2012年一样,参与者必须训练网络以获取来自1000个类别的120万张图像,正确类别中的5个可能的预测之一就是质量标准。

获胜的团队主要由Google员工组成,使用了具有22层神经元的GSS。 他们以LeNet-5命名他们的网络GoogLeNet。 根据达到前五个选项的标准,GoogLeNet达到了93.33%的准确度指标,这大大提高了2013年冠军(克拉里菲,从88.3%)和2012年冠军(KSH,从84.7%)的成绩。

GoogLeNet 93.33%的准确性如何? 2014年,一个研究小组对ILSVRC竞赛进行了

评论 。 解决的问题之一是人们将如何完成这项任务。 为了进行实验,他们创建了一个系统,使人们可以使用ILSVRC对图像进行分类。 正如该作品的作者之一,Andrei Karpaty在其博客中的翔实条目中解释的那样,将人们的有效性带入GoogLeNet指标非常困难:

即使对于我实验室中与ILSVRC及其类别合作了一段时间的朋友来说,要在1000种可能的五种类别中标记图像的任务也变得非常困难。 首先,我们想将该任务提交给Amazon Mechanical Turk。 然后,我们决定尝试以赚钱的方式雇用学生。 因此,我在实验室的专家中组织了一次评分会。 之后,我开发了一个经过修改的界面,该界面使用GoogLeNet预测将类别的数量从1000个减少到100个。但是,任务很艰巨-人们跳过了类别,错误率在13-15%左右。 最后,我意识到,为了更接近GoogLeNet的结果,最有效的方法是让我坐下来,经历一个漫长的学习过程以及随后的彻底标记过程。 最初,打标速度为每分钟1件,但随着时间的流逝而加速。 一些图像易于识别,而其他图像(例如某些犬种,鸟类或猴子)则需要几分钟的集中时间。 我擅长区分狗的品种。 根据我的图像样本,获得了以下结果:GoogLeNet在6.8%的情况下被误认为; 我的错误率为5.1%,大约提高了1.7%。

换句话说,只有通过认真努力,专家才能非常认真地工作,从而能够稍微领先于STS。 卡帕蒂(Karpaty)报告说,第二位专家接受了较少的图像培训,当每个图像最多选择5个标签时,该方法仅将错误减少了12%,这远低于GoogLeNet。

很棒的结果。 自这项工作问世以来,有几个团队报告了系统的开发情况,这些系统在选择5个最佳标签时的错误率甚至不到5.1%。 有时,这些成就被媒体报道为能够比人们更好地识别图像的系统的出现。 尽管结果通常是惊人的,但是有许多细微差别不能被认为计算机视觉在这些系统上比在人类系统上更有效。 在许多方面,ILSVRC竞争是一项非常有限的任务-在开放网络上进行图像搜索的结果不一定与该程序在实际任务中会遇到的结果相对应。 而且,当然,“五个最佳标记之一”的标准是相当人为的。 解决图像识别问题还有很长的路要走,更不用说计算机视觉的更一般的任务了。 但是,很高兴看到在短短几年内在解决这一艰巨任务方面取得了很大进展。

其他任务

我专注于ImageNet,但是还有许多其他项目使用NS进行图像识别。 让我简要描述一下最近获得的一些有趣的结果,只是为了了解现代工作。

Google的一个团队获得了一组鼓舞人心的实用

结果 ,并将GSS应用于Google Street View中的地址板识别任务。 在他们的工作中,他们报告了如何发现并自动识别将近1亿个地址板,其准确性可与人工媲美。 他们的系统速度很快:它能够在不到一个小时的时间内解密法国所有Google Street View图片中的数据! 他们写道:“在许多国家/地区,尤其是在没有其他地理编码来源的地方,获取这个新的数据集大大提高了Google Maps地理编码的质量。” 然后,他们发表了一个更笼统的声明:“我们相信,由于有了这种模型,我们才以适用于许多实际应用的方式解决了短序列的光学识别问题。”

也许我给人们留下了胜利和鼓舞人心的结果的印象。 当然,最有趣的报告涉及我们尚不清楚的基本问题。 例如,

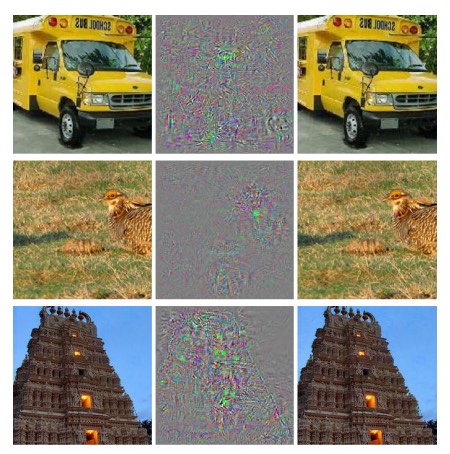

2013年的

工作表明,国民议会实际上存在盲点。 看一下下面的图片。 左侧是ImageNet的图像,研究人员网络对其进行了正确分类。 右侧是经过稍微修改的图像(中间显示了差异),网络不再能够正确识别该图像。 作者发现,可以从数据库中为任何图像选择这样的“对抗性”更改,而不仅仅是精英。

不愉快的结果。 我们使用的网络与KSH网络基于相同的代码-也就是说,越来越多的网络被使用。 而且,尽管这样的NS原则上计算连续函数,但是相似的结果表明它们可能会计算几乎离散的函数。 更糟糕的是,它们被证明是离散的,违反了我们对智能行为的直观概念。 这是一个问题。 另外,还不清楚是什么导致了离散,到底是什么问题:在损失函数中? 使用哪些激活功能? 在网络架构中? 还有别的吗? 我们不知道。

但是这些结果并不像看起来那样糟糕。 尽管这种对抗性变化非常普遍,但在实践中不太可能找到它们。 如工作所示:

对抗性否定词的存在与网络实现高度概括性的能力相矛盾。 的确,如果网络能够很好地推广,那么如何被这种与普通例子无异的对抗性负面因素欺骗呢? 解释是,一组对抗性否定极不可能发生,因此在训练数据集中不会被观察到(或几乎未观察到),但是它具有很高的密度(近似于有理数),因此几乎可以在任何情况下找到它。 。

然而,令人不快的是,我们对国民议会的工作了解得如此之差,以至于最近才发现这一结果。 当然,这种结果的主要优点是,它们刺激了有关该主题的后续工作的出现。

2014年的

最新工作表明,受过训练的网络可以创建对人来说看起来像白噪声的图像,并且该网络会高度自信地将其分类为知名类别。

这是在NS的工作及其在图像识别中的应用中,我们仍有很多要理解的演示。但是,尽管存在类似的结果,但总体情况还是令人鼓舞的。在执行诸如ImageNet之类的极其复杂的测试中,我们看到了快速的进步。我们还看到解决现实世界中的问题的快速进展,例如在StreetView中识别地址板。但是,尽管有灵感,但仅观察速度测试甚至实际任务的性能改进还是不够的。存在一些基本现象,例如,竞争性图像的存在,我们对它们的本质仍知之甚少。而且,尽管这些基本问题仍然存在(更不用说解决它们了),但现在谈论解决图像识别问题的解决方案还为时过早。但是同时,这些问题是进一步开展工作的良好动力。其他深度神经网络方法

在本书中,我们专注于一项任务:数字MNIST的分类。一项出色的任务使我们理解了许多有效的想法:随机梯度下降,反向传播,卷积网络,正则化等。但是,这也是一项相当狭窄的任务。阅读有关神经网络的文献之后,您会遇到许多我们没有讨论过的想法:重复出现的NS,Boltzmann机器,生成模型,培训的转移,强化学习等等!神经网络是一个广阔的领域。但是,许多重要的想法是我们已经讨论过的那些想法的变体,它们很容易理解。在本节中,我将略微揭开这些广阔领域的帷幕。他们的讨论将不详尽也不全面-这会使本书极大地膨胀。这将是印象派的试图展示这一领域的概念丰富性,并将一些概念与我们已经看到的概念联系起来。在本文中,我将参考其他资料,作为进一步培训的材料。当然,它们中的许多将很快被其他人取代,并且您可能想寻找更多最新的文献。尽管如此,我相信许多基本思想将在很长一段时间内保持有趣。递归神经网络(RNS)

在我们使用的直接传播网络中,有一个输入可以完全确定后续层中所有神经元的激活。这是一幅非常静态的图片:网络中的所有内容都是固定的,并且具有冻结的结晶特性。但是假设我们允许网络元素动态变化。例如,隐藏神经元的行为不仅可以通过先前层中的激活来确定,还可以通过时间较早时发生的激活来确定。神经元的激活可以通过其早期激活来部分确定。在具有直接分发的网络中,这显然不会发生。或者,也许隐藏和输出神经元的激活不仅取决于网络的当前输入,还取决于先前的神经元。具有这种时变行为的神经网络称为递归神经网络或RNS。有许多方法可以用数学方式形式化上一段的非正式描述。您可以通过阅读Wikipedia文章了解它们。在撰写本文时,本文的英文版至少描述了13种不同的模型[在2019年翻译时,已经是18种/大约。翻译]。

但是,如果我们抛开数学细节,那么RNS的一般思想是随着时间的推移网络中会出现动态变化。而且,毫不奇怪,它们对于分析随时间变化的数据或流程特别有用。这样的数据和过程自然会出现在诸如语音分析或自然语言之类的任务中。当前使用RNS的方法之一是通过图灵机和通用编程语言等概念,将神经网络与传统的算法表示方法更好地集成在一起。从2014年开始工作开发了RNS,能够接受一个非常简单的python程序的逐个字母描述,并预测其工作结果。非正式地讲,网络正在学习“理解”某些python程序。2014年的第二项工作将RNS用作图灵神经机器(BDC)开发的起点。这是一台通用计算机,可以使用梯度下降法训练其整个结构。他们训练了BDC来构建用于几个简单任务(例如排序或复制)的算法。这些当然是非常简单的玩具模型。学习如何像print(398345 + 42598)一样在python中运行程序不会使神经网络成为该语言的完整解释器!尚不清楚这些想法将有多强大。尽管如此,结果还是很有趣的。从历史上看,神经网络在识别偶然发现于传统算法方法的模式方面做得很好。反之亦然,传统的算法方法很好地解决了NS复杂的问题。今天,没有人试图实现基于NS的Web服务器或数据库!开发集成了NS和传统算法方法优势的集成模型将非常有用。 RNS及其受其启发的想法可以帮助我们做到这一点。近年来,RNS已用于解决许多其他问题。它们在语音识别中特别有用。基于RNS的方法创下了音素识别质量的记录。它们还用于开发人们使用的语言的改进模型。改进的语言模型有助于识别听起来相似的语音歧义。一个好的语言模型可以告诉我们,“前进到无穷远”这个短语比“前进而无肢”更容易,尽管它们听起来很相似。 RNS用于在某些语言测试中获得创纪录的成就。这项工作是广泛使用各种NS(不仅是RNS)来解决语音识别问题的一部分。例如,基于GNS的方法在识别具有大词汇量的连续语音时表现出出色的效果。Google在Android操作系统中实现了另一个基于GNS的系统。我谈了一些RNC的功能,但没有解释它们的工作方式。您可能会惊讶地发现,直接分销网络领域的许多想法也可以在RNS中使用。特别是,我们可以通过修改梯度下降和前额向后传播来训练RNS。直接分配网络中使用的许多其他想法,从正则化技术到卷积和激活以及成本函数,也将派上用场。另外,我们作为本书的一部分开发的许多想法都可以在RNS中使用。长期短期记忆(DCT)模块

RNS的问题之一是,早期模型很难训练,甚至比GNS还复杂。原因是不稳定的梯度问题,我们将在第5章中进行讨论。回想一下,此问题的通常表现是,当梯度沿相反的方向传播时,梯度始终会减小。这极大地减慢了早期学习的速度。在RNS中,此问题变得更加严重,因为梯度不仅沿层沿相反的方向传播,而且沿时间沿相反的方向传播。如果网络工作相当长的时间,则梯度会变得非常不稳定,并且在此基础上将很难学习。幸运的是,RNS中可以包含一个称为长期短期内存(DCT)模块的想法。这些模块首次引入Hochreiter和Schmidguber于1997年专门致力于解决不稳定梯度的问题。DCT使学习RNS的过程更容易获得良好的结果,并且许多最近的著作(包括我已经引用的著作)都使用DCT或类似的思想。深度信任网络,生成模型和Boltzmann机器

今天,在深培养兴趣在2006年得到了第二个风,作品(发行后1,2),介绍了如何培养一种特殊的NA称为信托(HSD)的深度网络。GDS影响了研究领域多年,但随后它们的普及率开始下降,直接分销网络和经常性的NS变得流行。尽管如此,GDS的某些属性仍然使它们非常有趣。首先,GDS是生成模型的一个示例。在直接分配网络中,我们指定输入激活,然后它们确定网络下方的特征神经元的激活。生成模型可以类似的方式使用,但是您可以在其中设置神经元的值,然后以“相反的方向”运行网络,生成输入激活的值。更具体地说,在手写数字图像上训练的GDS本身可以生成与手写数字相似的图像(可能并在某些操作之后)。换句话说,GDM在某种意义上可以学习写作。从这个意义上说,生成模型类似于人的大脑:它们不仅可以读取数字,还可以写入数字。众所周知说 杰弗里·辛顿指出对于模式识别,您首先需要学习如何生成图像。其次,他们有能力在没有老师和几乎没有老师的情况下学习。例如,在训练图像时,即使训练图像上没有标记,GDS也会学习有助于理解其他图像的信号。无论是从基础科学的角度还是从实践的角度来看,没有老师的学习能力都是非常有趣的-如果可以使其运作得足够好。鉴于GDS的所有这些吸引点都是深度学习的模型,为什么它们的普及率下降了?部分原因是其他模型(例如直接分布和循环网络)已经取得了惊人的成绩,特别是在图像识别和语音领域取得了突破。毫不奇怪,这些模型受到了如此的关注,并且是当之无愧的。然而,由此得出不愉快的结论。创意市场通常是按照“赢者得到一切”的方案运作的,几乎所有的注意力都集中在了该领域目前最流行的事物上。即使人们显然对他们不感兴趣,他们也很难解决当前不受欢迎的想法。我个人的观点是,GDS和其他生成模型应得到更多的关注。如果GDM或类似的模型超过当今流行的模型,我不会感到惊讶。已读本文旨在介绍GDM领域。本文可能也很有用。它并不完全与GDM有关,但是对于有限的Boltzmann机器(GDM的关键组件)有很多有用的东西。其他想法

国民议会和民防领域还发生了什么? 大量有趣的工作。 研究的活跃领域包括使用NS

处理自然

语言 ,

机器翻译以及更多意想不到的应用程序,例如

音乐信息学 。 还有许多其他领域。 在许多情况下,阅读本书后,您将能够了解最新的工作,尽管当然,您可能需要填补一些知识空白。

我将在本节结尾提到一个特别有趣的工作。 她将深层卷积网络与一种称为强化

学习的技术相结合,以

学习如何玩视频游戏 (以及有关该

游戏的 另一篇文章 )。 想法是使用卷积网络简化游戏屏幕中的像素数据,将其转换为一组更简单的属性,然后可用于做出有关进一步动作的决策:“向左”,“向右”,“射击”和“等 尤其有趣的是,一个网络学会了玩七个不同的经典视频游戏,远远领先于其中三个专家。 当然,这看起来像是一个把戏,并且在“使用强化学习玩Atari游戏”标题下积极宣传了该作品。 但是,在表面光泽的背后,值得考虑的事实是系统会获取原始像素数据-它甚至不知道游戏规则-并且在这些基础上训练它们可以在几种非常不同且竞争激烈的情况下做出高质量的决策,每种情况都有其自己的复杂规则集。 还不错

神经网络的未来

用户意图界面

在一个古老的笑话中,一位不耐烦的教授对一个困惑的学生说:“不要听我的话,听我的意思。” 从历史上看,计算机经常像迷茫的学生一样不理解用户的意思。 但是,情况正在改变。 我仍然记得我第一次对输入错误的请求感到惊讶,当时搜索引擎对我说:“您的意思是[正确的请求]吗?” Google总监拉里·佩奇(Larry Page)

曾将完美的搜索引擎

描述为一个系统,该系统可以准确了解您的查询的含义并为您提供所需的内容。

这是基于用户意图的界面的想法。 在搜索引擎中,搜索引擎将不响应文字用户的请求,而是使用MO接收模糊的用户请求,确切了解其含义并在此基础上采取行动。

基于用户意图的界面的想法可以被广泛应用,而不仅仅是在搜索中。 在接下来的几十年中,成千上万的公司将创建将MO用于用户界面的产品,冷静地指称不正确的用户操作,并猜测其真实意图。 我们已经看到了这种基于意图的界面的早期示例:Apple Siri; Wolfram Alpha; 沃森 自动标记照片和视频的系统等等。

他们中的大多数将失败。 界面开发是一件复杂的事情,我怀疑许多公司会在MO的基础上创建无生命的界面,而不是鼓舞人心的界面。 如果您的界面不好,世界上最好的MO不会帮您。 但是,某些产品将会成功。 随着时间的流逝,这将导致我们与计算机的关系发生重大变化。 例如不久前的2005年,用户就认为与计算机交互需要很高的准确性,这是理所当然的。 计算机的字面性质使人们传播了计算机非常字面化的观念。 唯一被遗忘的分号可以完全改变与计算机交互的性质。 但是我相信,在未来的几十年中,我们将根据用户的意图开发一些成功的界面,这将彻底改变我们使用计算机时的期望。

机器学习,数据科学和无懈可击的创新圈

当然,MO不仅用于基于用户意图创建接口。 MO的另一个有趣应用是数据科学,它用于搜索隐藏在获得的数据中的“已知未知数”。 这已经是一个时髦的话题,已经写了许多文章,因此我不会在很长的时间内扩展它。 我想提一下这种方式的一个后果,这种后果并不经常被注意到:从长远来看,莫斯科地区最大的突破可能不仅仅是一个概念上的突破。 最大的突破将是,通过使用科学和其他领域的数据,MO领域的研究将变得有利可图。 如果一家公司可以在MO研究上投入一美元,并且很快就能获得一美元和十美分的收入,那么很多钱将投入到MO地区。 换句话说,MO是驱动我们进入多个大型市场和技术增长领域的引擎。 结果,将出现该领域的大型人员专家团队,他们将拥有不可思议的资源。 这将使MO进一步发展,创造更多的市场和机会,这将是无懈可击的创新圈。

神经网络和深度学习的作用

我将MO概括地描述为为技术开发创造新机会的一种方式。 国民议会和公民社会在所有这方面的具体作用是什么?

为了回答这个问题,回顾历史是很有用的。 在1980年代,特别是在反向传播普及之后,与神经网络相关的活动得到了积极的快乐复兴和乐观。 但是恢复势头减弱,在1990年代,MO指挥棒被转移到其他技术上,例如支持向量法。 今天,国民议会再次站上台,创造各种记录,在各种问题上超越许多竞争对手。 但是谁能保证明天不会开发出一种新方法,而新方法又将使北美地区蒙上阴影? 或者,也许国民议会领域的进展将开始停滞,没有什么能取代它们?

因此,从整体上考虑国防部的未来要比专门考虑国民议会要容易得多。 问题的一部分是我们对国民议会的了解非常差。 为什么NS擅长汇编信息? 考虑到众多的选择,他们如何避免再培训这么好? 为什么随机梯度下降如此有效? 扩展数据集时,NS的运行状况如何? 例如,如果我们将ImageNet的基础扩展10倍,NS的性能会比其他MO技术的有效性提高多少? 所有这些都是简单的基本问题。 到目前为止,我们对这些问题的答案了解甚少。 在这方面,很难说国民议会将在莫斯科地区的未来中扮演什么角色。

我将做出一个预测:我认为GO不会走到任何地方。 研究概念层次结构,构建抽象的不同层次的能力显然是掌握世界知识的基础。 这并不意味着明天的GO网络将与今天的网络完全不同。 我们可能会在它们的组成部分,体系结构或学习算法上遇到重大变化。 这些变化可能足以让我们停止将最终的系统视为神经网络。 但是,他们仍将从事民防活动。

NS和GO会很快导致人工智能的出现吗?

在本书中,我们重点介绍了NS在解决特定问题(例如图像分类)中的使用。 让我们扩展一下查询:关于通用思维计算机呢? 国民议会和公民社会能否帮助我们解决创建通用AI的问题? 如果是这样,鉴于民防领域的高速发展,我们会在不久的将来看到AI的出现吗?

有关此问题的详细答案将需要单独购买。 相反,让我根据

康威定律为您提供一种观察:

组织设计系统限于复制该组织通信结构的设计。

举例来说,康威(Conway)的法律规定,波音747飞机的布局将反映波音747模型开发时波音及其承包商的扩展结构,或者另一个简单而具体的例子:考虑一家公司开发复杂软件。 如果软件控制面板应与MO算法连接,则面板设计人员应与公司的MO专家进行沟通。 康威(Conway)的法律只是将这一观察形式化。

许多人第一次听到康韦定律时,要么说“这不是一个普通的证据吗?”还是“是吗?” 我首先谈谈他的不忠。 让我们想一想:波音747会计如何反映? 那清洁部门呢? 喂养人员? 答案是组织的这些部分很可能不会明确出现在Scheme 747的其他任何地方。 因此,您需要了解Conway的法律仅适用于组织中直接参与设计和工程的那些部分。

关于平庸和证据的评论呢? 也许是这样,但我不这么认为,因为组织经常努力拒绝康威的法律。 开发新产品的团队通常由于员工数量过多而膨胀,或者相反,他们缺乏具有关键知识的人员。 考虑所有具有无用和复杂功能的产品。 或者考虑存在明显缺陷的产品-例如,糟糕的用户界面。 在这两种程序中,问题通常是由于发布优质产品所需的团队与真正组建的团队之间不匹配而引起的。 康韦的法律可能很明显,但这并不意味着人们不能经常忽略它。

在从一开始我们就可以想象产品将由什么组成部分以及如何制造的情况下,Conway的法律适用于系统的设计和创建。 它不能直接应用于AI的开发,因为AI还没有完成这样的任务:我们不知道它由什么组成。 我们甚至不确定您会问什么基本问题。 换句话说,目前,人工智能比工程师更是一个科学问题。 想象一下,您需要在不了解喷气发动机或空气动力学原理的情况下开始开发747th。 您将不知道要在组织中雇用哪些专家。 正如沃纳·冯·布劳恩(Werner von Braun)所说,“基础研究就是我不知道自己在做什么的时候在做的事情。” 康威法律是否有适用于与工程师比工程师与科学相关性更高的版本?

为了找到这个问题的答案,让我们回顾一下医学史。 在早期,医学是研究整个人体的从业者的领域,例如

Galen或

Hippocrates 。 但是随着我们知识量的增长,我不得不专门研究。 我们发现了许多深刻的想法-回顾疾病的微生物理论,或者了解抗体的运作原理,或者说心脏,肺,静脉和动脉形成了心血管系统。 这种深刻的思想为诸如流行病学,免疫学以及与心血管系统相关的重叠区域的积累等狭窄学科奠定了基础。 这就是我们的知识结构如何形成医学的社会结构。 在免疫学的情况下,这一点尤其明显:值得单独研究的免疫系统的存在是非常重要的。 因此,我们拥有整个医学领域-包括专家,会议,奖项等等,这些组织不仅围绕着看不见的东西,而且甚至没有分开的东西。

在许多已建立的科学学科中,事件的发展往往屡屡发生:不仅在医学领域,而且在物理学,数学,化学等领域。 地区是天生的整体,库存中只有很少的深层想法。 第一批专家能够涵盖所有内容。 但是随着时间的流逝,坚固性会发生变化。 我们发现了许多新的深刻的想法,而且对于一个人来说,太多的想法无法真正掌握它们。 结果,该地区的社会结构正在重新组织和分裂,集中于这些想法。 我们没有一个整体,而是一个领域,一个领域,一个领域,一个领域,一个自我引用的复杂,递归的社会结构,其组织反映了最深刻的思想之间的联系。 这就是我们的知识结构形成科学的社会组织的方式。 但是,这种社交形式反过来限制并有助于确定我们可以检测到的内容。 这是康威定律的科学类似物。

但是,这与深度学习或AI有什么关系?

好吧,从AI开发的早期开始

,就一直争论着一切都会变得“不太复杂,这要归功于我们的超级武器”,或者“超级武器将远远不够”。 深度学习是我见过的争端中使用的超级武器的最新示例。 在此类争端的早期版本中,使用了逻辑或Prolog或专家系统或某些其他技术,而当时这是最强大的技术。 此类争端的问题在于,它们没有给您机会确切地说出任何超级武器候选人的实力。 当然,我们只花了整整一章回顾了民防可以解决极其复杂的问题的证据。 它肯定看起来非常有趣并且很有前途。 但这对于Prolog或Eurisko等系统或专家系统来说就是这种情况。 因此,只有一组想法看起来很有希望这一事实并不意味着什么特别。 我们如何知道GO实际上与这些早期想法不同? 有没有一种方法可以衡量一套想法的强大性和前途性? 根据康威定律,我们可以将与这些想法相关的社会结构的复杂性用作粗略和启发式的指标。

因此,我们有两个问题。 首先,按照这种社会复杂性的度量标准,与公民社会有关的一套观念有多强大? 其次,我们需要一种强大的理论来创建通用AI?

关于第一个问题:当我们今天看民防时,这个领域看起来很有趣并且正在迅速发展,但是相对单一。 它有一些深刻的想法,并举行了几次主要会议,其中一些会议有很多重叠之处。 在工作中使用相同的想法集:随机梯度下降(或其近似等值线)可优化成本函数。 这些想法如此成功真是太好了。 到目前为止,我们还没有观察到很多发达的小区域,每个区域都将探索自己的深刻观念,这将使公民社会朝着许多方向发展。 因此,根据社会复杂性的度量标准,深度学习对双关语很抱歉,而它仍然是一个非常浅薄的研究领域。 一个人仍然能够掌握该领域的大多数深刻思想。

关于第二个问题:创建AI需要多少复杂而强大的想法集? 自然,答案将是:没人能确定。 但是在这本书的后记中,我研究了有关该主题的一些现有证据。 我得出的结论是,即使根据乐观的估计,创建AI也会需要许多非常深刻的想法。 根据康韦定律,要达到这一点,我们必须看到许多相互关联的学科的出现,它们具有复杂而出乎意料的结构,反映了我们最深层思想的结构。 使用NS和民防时,我们尚未观察到如此复杂的社会结构。 因此,我相信,至少距离使用GO开发通用AI还要几十年。

我花了很多精力来创建一个推测性的论点,这似乎很明显,并且没有得出一定的结论。 这肯定会使那些追求确定性的人失望。 我在网上遇到很多人,他们通常是根据不稳定的论据和不存在的证据公开宣布他们对AI的非常肯定和自信的看法。 我可以诚实地说:我认为判断还为时尚早。 就像在一个古老的笑话中一样:如果您问一位科学家,我们需要等待多少时间,而他说“ 10年”(或更长时间),那么实际上他的意思是“我不知道”。 在人工智能出现之前,就像受控核聚变和其他一些技术一样,“ 10年”已经存在了60多年。 另一方面,我们在民防领域肯定拥有的是一项有效的技术,我们尚未发现其局限性,还有许多悬而未决的基本任务。 它创造了惊人的创造机会。