哈伯,你好。

这篇文章是一般机器学习算法的简要概述。 每篇文章均附有简要说明,指南和有用的链接。

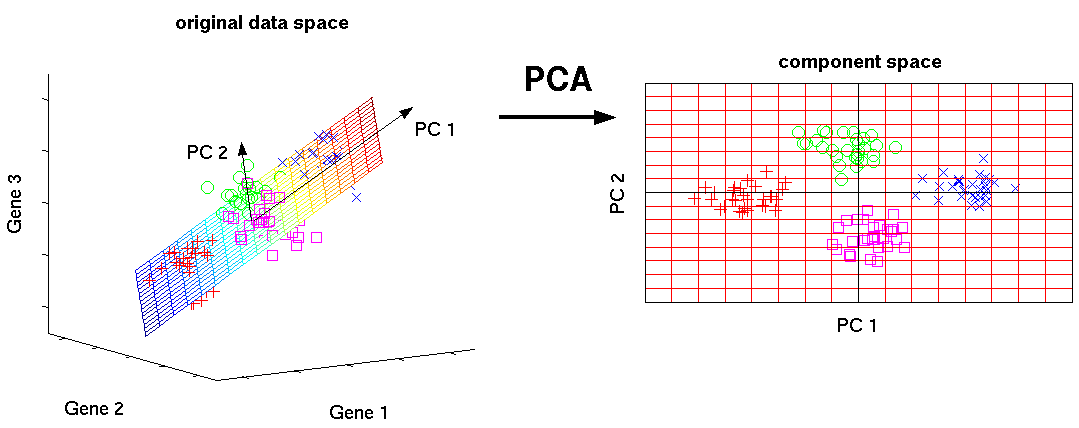

主成分法(PCA)/ SVD

这是基本的机器学习算法之一。 使您可以减少数据的维数,而丢失的信息量最少。 它用于许多领域,例如对象识别,计算机视觉,数据压缩等。主要成分的计算减少到计算源数据协方差矩阵的特征向量和特征值或数据矩阵的奇异分解。

SVD是一种计算有序分量的方法。

有用的链接:

入门指南:

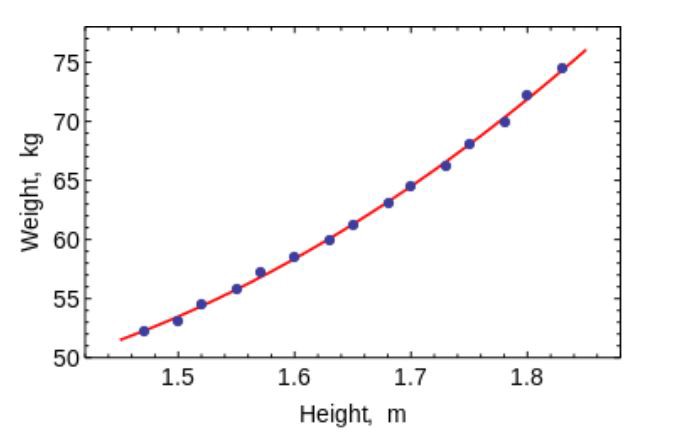

最小二乘法

最小二乘法是一种数学方法,用于基于最小化某些函数与所需变量的偏差的平方和的基础来解决各种问题。 它可用于“求解”超定方程组(当方程组数量超过未知数时),在普通(未重新定义)的非线性方程组情况下可以找到一个解决方案,并且可以近似一个函数的点值。

使用此算法拟合简单曲线/回归。

有用的链接:

入门指南:

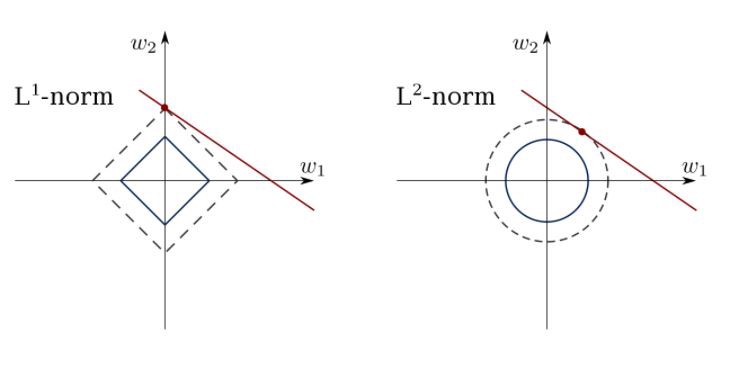

有限线性回归

最小二乘法会混淆离群值,假字段等。需要约束以减少我们放入数据集中的线的方差。 正确的解决方案是拟合线性回归模型,该模型可确保权重不会表现“不好”。 模型可以具有标准L1(LASSO)或L2(Ridge回归)或同时具有两者(弹性回归)。

使用此算法来匹配约束回归线,避免覆盖。

有用的链接:

入门指南:

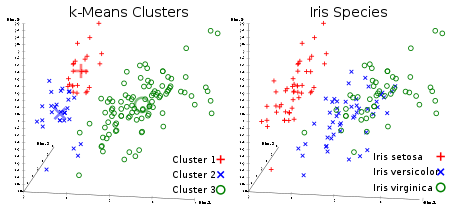

K均值法

每个人最喜欢的不受控制的聚类算法。 给定矢量形式的数据集,我们可以基于它们之间的距离创建点的群集。 这是一种机器学习算法,可以按顺序移动聚类的中心,然后将点与聚类的每个中心进行分组。 输入是要创建的集群数和迭代数。

有用的链接:

入门指南:

逻辑回归

Logistic回归仅限于在应用权重后进行非线性线性回归(主要使用S型函数或tanh),因此,输出限制接近+/-类(在S型中为1和0)。 使用梯度下降法优化了交叉熵损失函数。

初学者注意:逻辑回归用于分类,而不是回归。 通常,它类似于单层神经网络。 使用优化技术进行训练,例如梯度下降或L-BFGS。 NLP开发人员经常使用它,称其为“最大熵分类”。

使用LR训练简单但非常“强大”的分类器。

有用的链接:

入门指南:

SVM(支持向量法)

SVM是线性模型,例如线性/逻辑回归。 区别在于它具有基于保证金的亏损功能。 您可以使用诸如L-BFGS或SGD之类的优化方法来优化损失函数。

SVM可以做的一件事是学习类分类器。

SVM可用于训练分类器(甚至是回归器)。

有用的链接:

入门指南:

直接分布神经网络

基本上,这些是逻辑回归的多级分类器。 权重的许多层由非线性分开(S型,tanh,relu + softmax和冷却新的selu)。 它们也称为多层感知器。 FFNN可作为自动编码器用于分类和“无师傅训练”。

FFNN可用于训练分类器或提取功能作为自动编码器。

有用的链接:

入门指南:

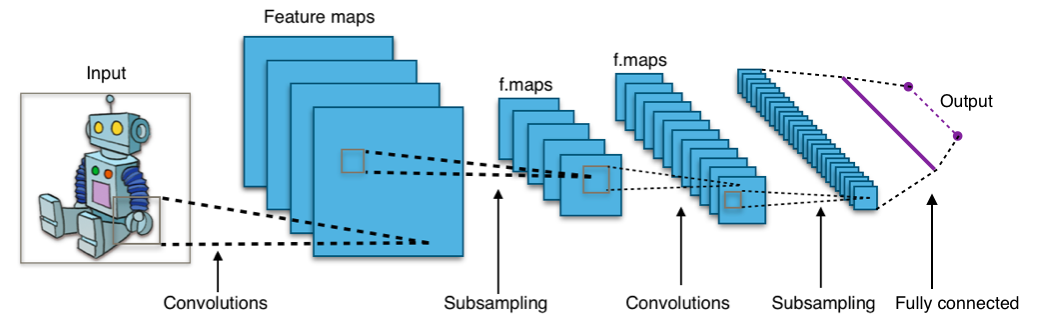

卷积神经网络

机器学习领域几乎所有的现代成就都是使用卷积神经网络实现的。 它们用于对图像进行分类,检测对象甚至分割图像。 网络由Jan Lekun在90年代初期发明,网络具有卷积层,可作为对象的分层提取器。 您可以使用它们来处理文本(甚至可以处理图形)。

有用的链接:

入门指南:

递归神经网络(RNN)

RNN通过对时间t处的聚合器状态和时间t处的输入递归地应用相同的权重集来对序列进行建模。 纯RNN目前很少使用,但在大多数序列建模任务中,其同类产品(例如LSTM和GRU)是最先进的。 LSTM,代替纯RNN中的简单密集层。

将RNN用于文本分类,机器翻译,语言建模的任何任务。

有用的链接:

入门指南:

条件随机场(CRF)

它们像RNN一样用于序列建模,并且可以与RNN结合使用。 它们还可以用于其他结构化的预测任务,例如图像分割。 CRF对序列的每个元素(例如,一个句子)建模,以便邻居影响序列中组件的标签,而不是影响彼此独立的所有标签。

使用CRF链接序列(文本,图像,时间序列,DNA等)。

有用的链接:

入门指南:

决策树和随机森林

最常见的机器学习算法之一。 用于预测模型的统计和数据分析。 结构是“叶子”和“分支”。 目标函数所依赖的属性记录在决策树的“分支”上,目标函数的值记录在“叶子”中,区分情况的属性记录在其余节点中。

要对新案例进行分类,您需要将树下移至叶子并发出相应的值。 目标是创建一个模型,该模型根据多个输入变量来预测目标变量的值。

有用的链接:

入门指南:

通过在

Habré和Telegram频道

Neuron上订阅我的帐户,您将学到更多有关机器学习和数据科学的信息。 不要跳过以后的文章。

所有的知识!