确定AI的水平是计算机科学领域中最困难的问题之一,也是最重要的问题之一。 如果您不能确定今天创建的计算机是否比昨天创建的计算机更智能,那么如何确定自己正在进步?

乍一看,这似乎根本不是问题。 关于这一问题的观点之一是“当然,人工智能正在变得越来越智能”。 “只要看看所有涌入该行业的金钱和才华横溢的人。 看看成就,例如在GO中打败人们,以及十年前无法解决的各种任务,但是今天它们已变得司空见惯,例如图像识别。 这真的没有进展吗?

另一种观点是,这些成就不是智力的良好指标。 是的,在国际象棋和围棋中击败人的经历令人印象深刻,但是,即使最聪明的计算机在解决儿童或老鼠的一般性问题时会丢失,这又有什么关系呢?

这项批评来自人工智能研究员FrançoisCholet,他是Google软件工程师,并且是机器学习社区中的知名人士。 Cholet是Keras的创建者,Keras是一个非常流行的用于创建神经网络的库。 他还撰写了许多机器学习教程,并维护了一个流行的

Twitter帐户,以评论各种行业事件。

在最近的一篇文章“

关于衡量智能 ”中,Cholet还指出,人工智能界必须决定什么是智能,什么不是智能。 根据Cholet的说法,如果研究人员希望在创建通用人工智能方面取得进展,那么他们应该停止关注流行的基准测试,例如视频游戏或棋盘游戏,而您应该开始考虑真正使人变得更聪明的技能,例如我们的概括能力和适应。

在对即将到来的《 The Verge》的一次采访中,Cholet解释了他对此主题的想法,解释了为什么他认为AI领域的当前成就已被“扭曲”,我们如何衡量未来的智能以及为何有关超级智能AI的恐怖故事( (由埃隆·马斯克(Elon Musk)等人讲),在公众的想象力中占据了过多的注意力。

为了清楚起见,对采访进行了少量编辑。

在您的文章中,您描述了影响AI领域的两种不同的智能概念。 前者将智能描述为能够在各种任务中成功的能力,而后者则将适应性和概括性放在首位,即AI应对新挑战的能力。 现在哪个概念更具影响力,其后果是什么?在该行业历史的前30年中,第一个概念最受欢迎:将智能作为一组静态程序和明确的知识库。 目前,钟摆已朝着相反的方向非常强烈地摆动:将情报表示为“干净的板岩”,或者使用更恰当的隐喻表示为“刚刚初始化的深度神经网络”。 不幸的是,这个概念几乎没有受到质疑,也没有得到广泛的研究。 这些问题已经在科学界讨论了很长时间-实际上是几十年了-但是现在我看不到参与深度学习的人们之间的意识,这也许是因为其中大多数人是在2016年之后进入这一领域的。

仅有一种观点的知识垄断永远都不是好事,特别是作为对理解不充分的科学问题的解答。 这限制了所提出的问题。 它限制了人们可能提出的想法的数量。 我认为研究人员现在已经意识到了这一事实。

在您的文章中,您还指出,改善AI需要对情报进行更准确的定义。 您声称研究人员现在专注于基准测试和统计测试,例如获胜的视频游戏和棋盘游戏。 你为什么错过这个智商?事实是,选择这种措施,您将使用所有可用的漏洞(快捷方式,缩短的路径)来实现它。 例如,如果您选择下棋来衡量智力(这是从1970年代到1990年代),那么最终会得到一个下棋的系统,而没有其他任何东西。 没有理由相信该系统将对其他任何方面都有利。 结果,您会得到一棵搜索树和minimax,它没有说明人类的智能。 如今,在诸如Dota或StarCraft之类的视频游戏中追求精通就陷入了同一个智力陷阱。

也许这并不明显,因为在人类中,技能和智力密切相关。 人脑可以利用其通用智能来掌握这项任务的特殊技能。 真正擅长国际象棋的人可以被认为是非常聪明的人,因为间接地,我们知道他们是从头开始的,必须使用他们的通用情报来学习如何下棋。 他们不是下棋的。 因此,我们知道他们可以将通用情报引导到其他任务,并学习如何以类似方式执行这些任务。 这就是多功能性。

但是与汽车有所不同。 可以设计用于下棋的机器。 因此,我们对人的结论-“因此可以下棋,必须很聪明”-崩溃了。 我们的拟人化假设将不再适用。 通用情报可以掌握特定于任务的技能,但是没有从特定任务的技能转向通用情报。 绝对是 因此,在汽车中,技能和智力是完全不同的两件事。 如果您可以收集关于任务的无限量的数据(或花费无限量的工程资源),则可以在任意任务上获得任意技能。 而且它仍然无法使您更接近通用情报。

这里的关键点是,获得高技能不会成为智力的标志。 仅当任务不是真正的元任务,并且要解决该问题时,才有必要在一系列以前未知的问题中获得新技能。 这就是我建议测量智力的方法。

如果当前的测试不能帮助我们开发具有更通用和更灵活的智能的AI,那么为什么它们如此受欢迎?

如果当前的测试不能帮助我们开发具有更通用和更灵活的智能的AI,那么为什么它们如此受欢迎?毫无疑问,在著名的视频游戏中击败冠军人物的努力主要是由于这样的项目吸引了众多媒体的关注。 如果公众对这些惊人的“成就”不感兴趣,可以很容易地将其想象成在实现超人AI方面的进展,那么研究人员会做其他事情。

这让我有些难过,因为研究应该回答开放的科学问题,而不要从事PR。 如果我打算通过深度培训在超人的水平上“解决” Warcraft 3,则可以绝对确定,只要我们具备开发才能和足够的计算能力(解决这一问题将花费数千万美元),一切都会顺利进行。 但是,这样做之后,我将从智能或多功能中学到什么呢? 没事 在最佳情况下,我将获得工程知识以扩展深度学习。 因此,我不认为这是一项科学研究,因为它没有教授我们尚不知道的知识。 我们不会回答一个开放性问题。 如果问题是:“我们可以在超人的水平上玩X吗?”,答案是明确的:“是的,如果您可以产生很多训练情况,并用相当有表现力的深度学习模型来表示它们。” 我们已经知道了一段时间(

实际上,我是在AI达到Dota 2和Starcraft的冠军级别之前说过这一点的。 )

您认为这些项目的真正成就是什么? 他们的结果在多大程度上被误解或扭曲?我看到的一个严重失真是,这些高级游戏系统代表了朝着“人工智能系统及其应对现实世界的复杂性和不确定性的能力”的真正进步[这是从新闻稿中的OpenAI声明到其OpenAI的五个方面。机器人玩Dota 2]。 但是他们不能。 如果是这样,那么这些研究将是非常有用的,但是事实并非如此。 例如,以OpenAI五:他无法应付Dota 2的复杂性,因为他接受过16个角色的训练,并且他无法将知识传播到整个游戏中,游戏中有超过100个字符。 训练它花了45,000年的时间-再次,注意训练数据的要求随任务的复杂性而增长-但是,最终的模型却非常脆弱:非冠军玩家可以找到策略来击败机器人AI公开发布几天后。

如果您想学习如何应对现实世界的复杂性和不确定性,则应该开始提出以下问题:智能的普遍性是什么? 我们如何衡量和提高学习系统的多功能性? 这与我们现在所做的完全不同,当我们将一个大型神经网络中的数据多出10倍时,它将其技能提高了百分之几。

那么,哪种智能措施最适合该行业?简而言之,我们应该停止评估象棋,Dota或《星际争霸》等已知任务的技能,而应该开始评估系统获取技能的能力。 这意味着我们应该只使用系统以前不知道的新任务,测量对系统启动时的任务的初步了解,并测量系统的有效性(需要多少数据来学习如何完成任务)。 获得一定水平的技能所需的信息(先验知识和经验)越少,您就越聪明。 鉴于以上所述,实际上,现代人工智能系统不是很聪明。

此外,通过这种智能度量,机器将看起来更像人,因为可以存在不同类型的智能,而人类智能就是我们在谈论通用智能时所间接指的。 这还包括尝试了解人们出生于世界的哪些知识。 人们非常有效地学习-他们只需要很少的经验就可以学习新技能-但是他们并不会从头开始。 除了使用一生中积累的技能和知识外,他们还使用先天知识。

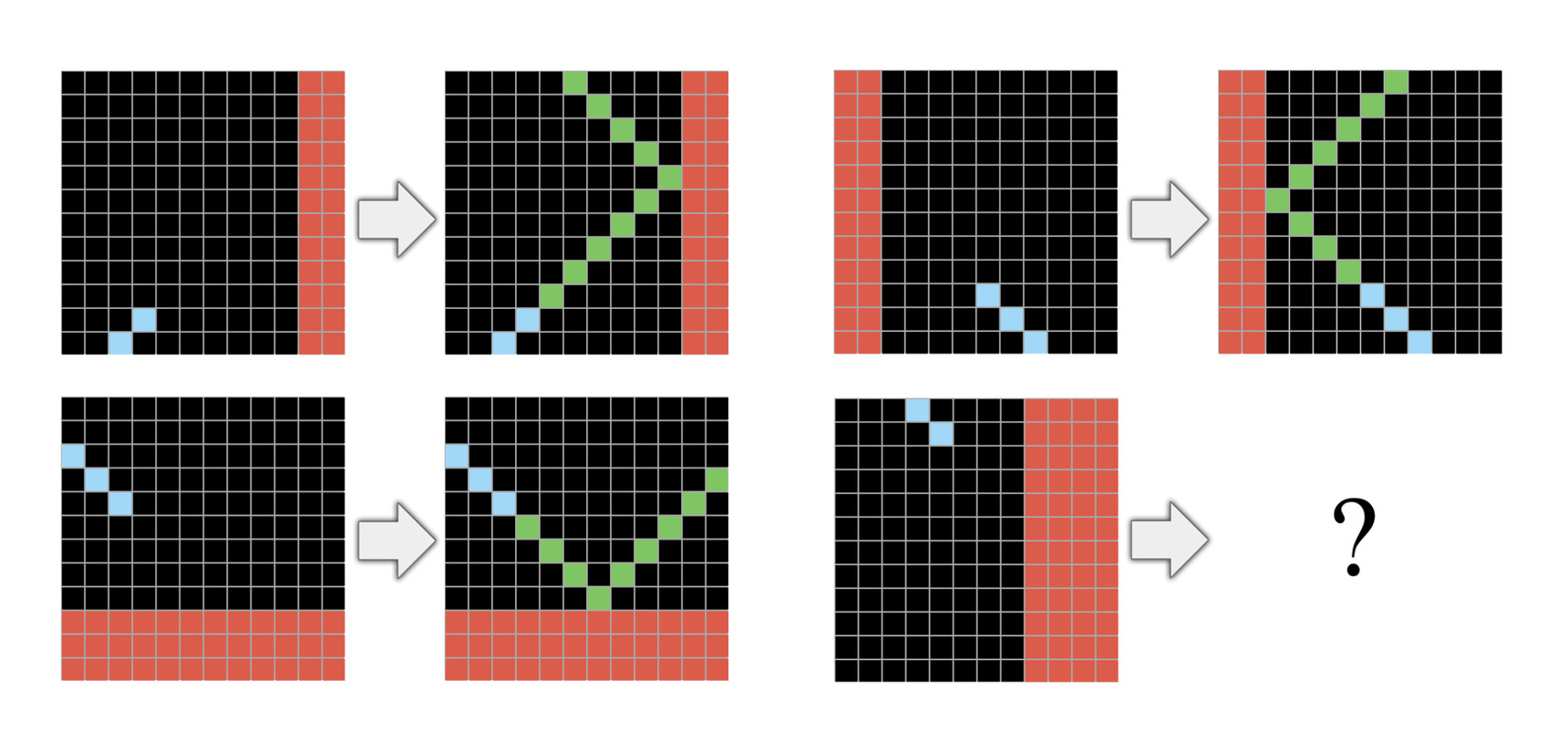

在我最近的文章中,我提出了一个新的评估数据集ARC,它与IQ测试非常相似。 ARC是一组心理任务,其中每个任务都按简短的演示顺序(通常是三个)进行解释,您必须从这几个演示中学习如何完成任务。 ARC的想法是,评估您的系统的每个任务都应该是全新的,并且仅包含与人类先天知识一致的知识。 例如,人类语言不能用于此类任务。 当前,人们无需任何口头解释或初步准备就可以解决ARC,但是目前已知的AI系统都无法解决它。 这是我们需要新想法的重要标志。

您是否认为仅通过增加计算能力来解决问题,人工智能界就能继续发展? 有人认为 ,多年来,这一直是提高生产率的最有效方法。 当其他人建议我们走这条路时,结果和增长率将开始恶化。

您是否认为仅通过增加计算能力来解决问题,人工智能界就能继续发展? 有人认为 ,多年来,这一直是提高生产率的最有效方法。 当其他人建议我们走这条路时,结果和增长率将开始恶化。如果您正在执行特定任务,这绝对是正确的。 对垂直任务使用更多的训练数据和更多的计算能力将提高此任务的生产率。 但这将使您对如何实现人工智能的多功能性几乎没有任何了解。

如果您有足够大的深度培训模型并提供了很好的任务样本,那么它将学到如何解决此问题,无论是Dota还是StarCraft。 这是非常有价值的。 这可以用于几乎无限数量的与机器感知有关的任务中。 唯一的问题是,相对于任务的复杂性,您需要的数据量是组合功能,因此,即使是稍微复杂的任务也可能变得过于昂贵。

以自动驾驶汽车为例。 对于仅使用深度培训来学习如何安全驾驶的模型来说,数百万的培训情况是不够的。 这就是为什么我们还没有5级自动驾驶仪的原因。 在最先进的自动驾驶系统中,深度学习主要用于链接传感器数据和手动创建的模型。 如果我们拥有通用深度学习,那么到2016年,我们将以一个大型神经网络的形式拥有5级自动驾驶仪。

最后,鉴于您正在谈论现代AI的局限性,在我看来,值得担心的是,强大的AI可能在不久的将来损害人类。 您认为这些是有充分根据的恐惧吗?不,我不相信这个想法的正确性。 我们从未创建过独立的AI。 而且绝对没有迹象表明我们可以在可预见的将来创建它。 (人工智能行业现在并没有朝这个方向发展。)我们甚至无法想象如果我们在遥远的将来最终创造出它的特征。 如果您想进行类比,那就像在1600年问:“弹道学发展非常迅速! 但是,如果我们曾经拥有可以摧毁整个城市的枪支,那该怎么办? 我们如何确定她只会杀死坏人?” 这是一个措辞很差的问题,在缺乏有关未来AI的任何确切知识的情况下,其讨论最多只能归结为哲学论证。

但是,这些对智能的担忧分散了人们对其他领域的关注,而在这些领域中,人工智能今天可能非常危险。 没有超级情报,使用AI的某些方法会很危险。 我写了关于如何将AI用于算法宣传系统的文章。 关于在武器系统中使用AI的日益增长的趋势或关于AI作为极权主义控制工具的越来越多的报道。

关于1453年君士坦丁堡被围困的故事。 当这座城市与奥斯曼帝国军队作战时,其学者和统治者们讨论了什么样的天使可以成为性别。 而且,我们投入更多的精力和精力投入有关天使性别的辩论,或者通过思考超级智能AI应该具有的价值观,我们对解决紧迫和现实问题的关注就越少。 一位著名的IT领导者喜欢谈论超智能AI是对人类的主要威胁。 好吧,尽管这些想法占据了所有头条新闻,但您没有在讨论在我们的道路上生产自动驾驶仪不够准确的汽车是否合乎道德,这会导致事故和死亡。

如果您接受这种批评-目前没有这些恐惧的技术依据-您认为为什么它们如此受欢迎?我认为这只是一个美丽的故事,人们喜欢它。 一切都令人想起一个关于世界末日的宗教故事,这并非巧合,因为这样的故事在人们中流传了很长时间。 出于同样的原因,这种恐惧通常在科幻电影和小说中使用。 那是因为这是一个美丽的故事。 人们需要故事来了解世界。 这样的故事比了解智能的本质或了解推动技术进步的原因要多得多。

Telegram频道中还有更多有趣的作品。